来源:财联社

编辑 潇湘

自从年内生成式人工智能热潮兴起以来,有关数据安全性的争议就始终不断。而据一家网络安全公司的最新研究显示,微软公司的人工智能研究团队数月前就曾意外在软件开发平台GitHub上泄露了大量私人数据,其中涵盖了3万多条微软团队的内部信息。

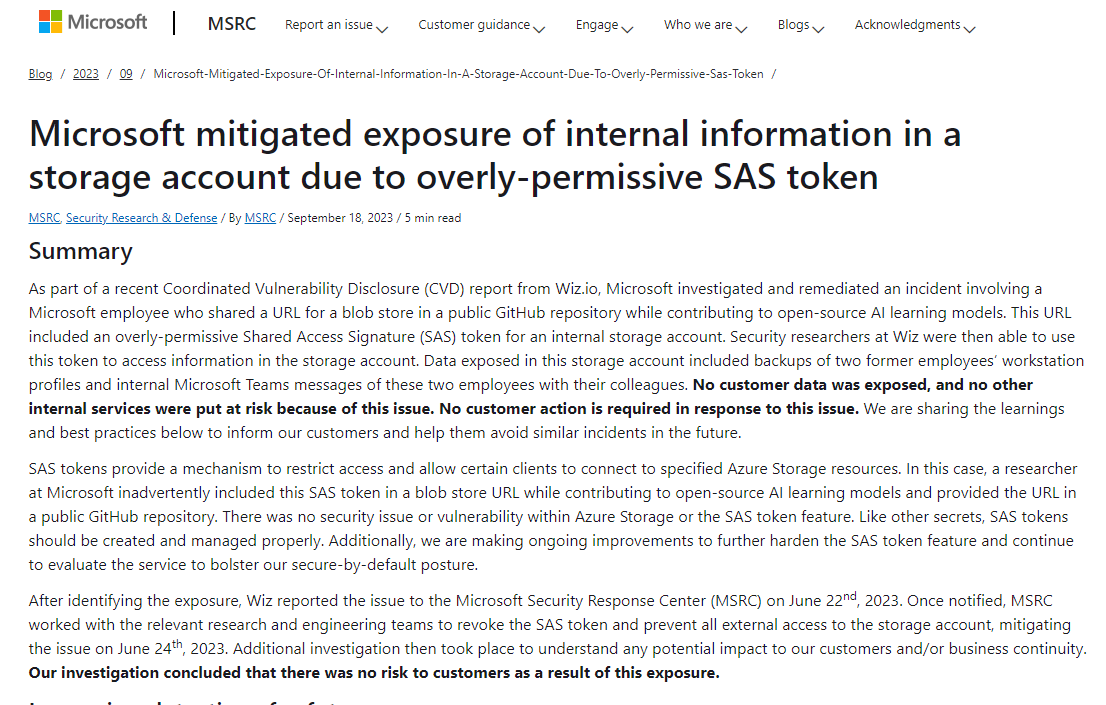

云安全公司Wiz的一个团队发现,微软的研究团队今年6月在GitHub上发布开源训练数据时泄露了这些数据。这些云托管数据是通过一个配置错误的链接泄露的。

根据Wiz的一篇博客文章,微软的AI研究团队原本在GitHub上发布了开源训练数据,但由于SAS令牌的错误配置,其错误地配置为授予整个存储账户的权限,而且还授予用户完全控制权限——还不单单是只读权限,这意味着他们可以删除和覆盖现有文件。

据Wiz称,被泄露的总计38TB的数据中,包含了微软两名员工个人电脑上的磁盘备份,而这些备份中又包含了微软服务的密码、密钥和来自359名微软员工的3万多条微软团队内部信息。

Wiz的研究人员表示,开放数据共享是AI训练中的关键组成部分,但如果使用不当,共享大量数据也会使公司面临极大的风险。

Wiz公司首席技术官兼联合创始人Ami Luttwak指出,Wiz公司在6月份与微软共享了这一情况,微软很快就删除了被暴露的数据。Wiz研究团队是在互联网上扫描配置错误的存储器时发现这些数据缓存的。

对此,微软发言人事后发表评论称,“我们已经确认,没有客户数据被暴露,也没有其他内部服务受到威胁。”

微软在周一发表的一篇博文中表示,公司已调查并补救了一起涉及一名微软员工的事件,该员工在公共GitHub存储库中向开源人工智能学习模型共享了一个URL。微软表示,存储账户中暴露的数据包括两名前员工工作站配置文件的备份,以及这两名前员工与同事的微软团队内部信息。

本站所有软件信息均由用户上传发布,版权归原著所有。如有侵权/违规内容,敬请来信告知邮箱:764327034@qq.com,我们将及时撤销! 转载请注明出处:https://czxurui.com/zx/87333.html

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

发表回复

评论列表(0条)