原文来源:阿尔法公社

图片来源:由无界 AI生成

在AIGC大爆发的背后,是海量AI训练和AI推理的算力需求。英伟达是目前最大的AI算力提供商,它第二季度的盈利水平(同比增长854%)传递了一个信号—行业对于AI算力的需求还远未被满足。

英伟达在AI算力的垄断之势(市场份额超80%),让很多使用AI算力的公司担忧,微软、亚马逊和OpenAI都在积极造芯,OpenAI还和Cerebras ,Atomic Semi等AI芯片创业公司传出了收购绯闻。

运行AI应用的AI推理算力需求在未来将会大大超过训练大模型的算力需求,而且推理算力的要求与训练并不相同,现有的GPU去做推理,在成本上没有优势,这就需要专有的AI推理芯片。

近日,一家专注做AI推理芯片的创业公司d-Matrix获得了1.1亿美元B轮融资,由淡马锡领投,包含此前融资轮次的投资者有Playground Global、M12(微软风险投资基金)、Industry Ventures、Ericsson Ventures、Samsung Ventures、SK Hynix等,产业投资占了相当重要的部分。d-Matrix的首席执行官Sid Sheth表示:“他们是懂得如何建立半导体业务的资本,是可以与我们长期合作的资本。”

d-Matrix的新融资将用来打造其数字内存计算 (DIMC) Chiplet推理计算卡Corsair。这种卡据称推理速度是英伟达H100 GPU的9倍,如果是计算卡集群,与英伟达的类似解决方案相比,功率效率提高20倍,延迟降低20倍,成本降低高达30倍。

两位芯片资深人士瞄准AIGC时代的AI推理算力需求

AI系统在训练AI模型与使用它进行预测和推理时使用不同类型的计算。AI推理需要的算力更少,但是当运行一个大型AI服务时,长期看需要比训练更多的算力。

使用现有的AI硬件很难低成本地部署一个专门用于AI推理的数据中心。有消息称,微软的GitHub Copilot服务,平均每个月在每个用户身上要倒贴20美元,据SemiAnalysis首席分析师Dylan Patel统计,OpenAI运行ChatGPT的单日投入成本可能高达70万美元。这些成本,都是运行AI服务时无法缩减的AI推理成本。

AI行业要更健康的发展,更低推理成本,更低能耗成本的AI推理芯片是刚需。

两位芯片行业的资深人士Sid Sheth和Sudeep Bhoja于2019年创立了d-Matrix,他们此前曾在Marvell和Broadcom(博通)共事。2019年,Transformer架构的AI模型刚刚兴起,他们看到了这个模型架构的巨大潜力和机会,决定专门为这些大语言模型设计其AI硬件。

d-Matrix的首席执行官兼联合创始人Sid Sheth表示:“我们在2019年做了一个赌注,决定专注做Transformer模型的加速平台,并且专注于推理,到2022年底,生成式AI爆发时,d-Matrix成为少数几家拥有生成式AI推理计算平台的公司之一。我们在三年的时间里逐渐成长并抓住了这个机会。我们所有的硬件和软件都是为了加速Transformer模型和生成式AI构建的。”

Sid Sheth继续介绍了d-Matrix在市场定位上的独特性:“生成式AI将永远改变人们和公司创造、工作和与技术互动的范式。

但是当前运行AI推理的总体拥有成本 (TCO) 正在迅速上升,d-Matrix团队正在通过为大语言模型专门打造的计算解决方案,改变部署AI推理的成本经济学,而这轮融资进一步证实了我们在该行业中的地位。”

微软M12的投资人Michael Stewart认为:“当大语言模型推理的TCO成为企业在其服务和应用中使用先进AI的关键限制因素时,我们正式进入生产阶段。d-Matrix一直在遵循一个计划,该计划将为使用基于内存为中心方法的灵活、弹性的Chiplet架构的各种潜在模型服务场景提供行业领先的 TCO。”

将AI推理的成本降低30倍

使用CPU和GPU进行AI的训练和推理,并不是效率最高的方式。对于AI推理运算,数据移动是最大的瓶颈。具体来说,将数据来回传输到随机存取存储器会导致显著的延迟,这又会导致更高的能耗和成本,并拖慢整个AI系统的速度。

解决这个问题,可以有三种方式。

第一种是通过采样和流水线减少处理的数据量来加速深度学习,但它也限制了准确性和精确性。

第二种是在传统的处理器附近设置专用AI引擎的处理器,Apple、英伟达、Intel和AMD都采用这种方式,但这些解决方案仍然使用传统的冯·诺依曼处理器架构、要集成SRAM和外部DRAM存储器,他们都需要将数据移入和移出存储器,仍然造成高能耗和低效率。

第三种是将计算移动到RAM(内存)附近,也就是d-Matrix采用的方法。这种叫数字内存计算(DIMC)的引擎架构降低了延迟,减少了能源消耗。它也非常适合AI推理,因为推理会涉及一个相对静态(但大型)的权重数据集,这个数据集被反复访问,DIMC消除了大部分能量转移费用和数据移动的延迟。

d-Matrix使用多个Chiplet来构建更大、模块化且可扩展的集成电路。这使它能够构建可扩展的平台,用于企业级AI推理任务,帮助AI企业提高性能和效率。

Jayhawk II Chiplet

2021年,d-Matrix推出了Nighthawk Chiplet,之后,他们推出了Jayhawk Chiplet平台,这是行业首款基于Open Domain-Specific Architecture(ODSA)Bunch of Wires(BoW)的Chiplet平台,旨在提供高能效的基于有机基板的芯片间连接。

而首批采用d-Matrix的DIMC架构的产品将基于最近宣布的Jayhawk II处理器,这是一个包含约165亿晶体管的Chiplet。

每个Jayhawk II Chiplet都包含一个RISC-V核心来管理它,32个Apollo核心(每个核心有八个并行操作的DIMC单元)、带有150TB/s带宽的256 MB SRAM。核心使用带有84TB/s带宽的特殊网络芯片进行连接。

Corsair计算卡

d-Matrix还推出了Corsair计算卡,类似英伟达的H100,每块Corsair计算卡拥有8个Jayhawk II Chiplet,每个Jayhawk II提供2Tb/s(250GB/s)的芯片到芯片带宽,单块Corsair计算卡就拥有8Tb/s(1TB/s)的聚合芯片到芯片带宽。

d-Matrix的架构和软件的可扩展性使其能够将集成的SRAM内存聚合成一个提供非常高带宽的统一内存池。例如,带有16张Corsair卡的服务器有32 GB的SRAM和2TB的LPDDR5,这足以运行200亿到300亿参数的Transformer模型。

d-Matrix声称,与基于GPU的解决方案相比,搭载Corsair计算卡的服务器使生成式AI的推理总体拥有成本降低了10倍到30倍,但是这一套硬件将在2024年才能正式投入使用。

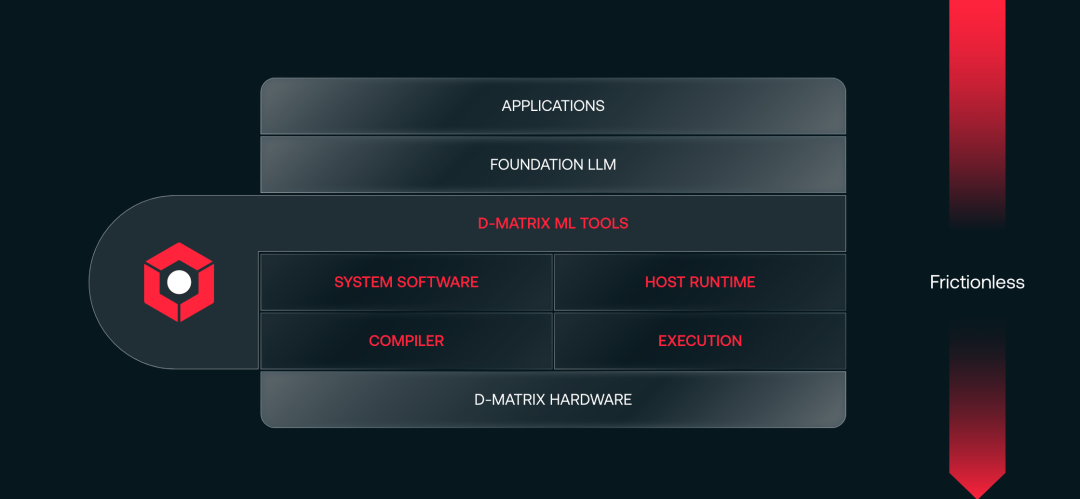

d-Matrix Aviator软件堆栈

英伟达在AI算力的强大不仅在于GPU,也在于它的CUDA软件堆栈以及为特定工作负载和用例优化的众多库,从而形成了完整生态。

d-Matrix也用Aviator软件堆栈与硬件一起为客户提供完整体验,它包含了一系列用于生产中部署模型的软件,例如ML工具链、用于工作负载分配的系统软件、用于生产部署的推理服务器软件等。而且其大部分软件堆栈都利用了广泛采用的开源软件。

瞄准相对较小的模型

d-Matrix的首席执行官Sid Sheth指出,除了定位在AI推理外,它们还进一步专注在数十亿到数百亿的中小大模型,而不是通用的千亿以上大模型。

半导体和AI研究机构Cambrian AI的创始人兼首席分析师Karl Freund也同意这种观点,他表示:“大多数企业不会部署千亿或万亿参数大模型。但他们会使用公司的自有数据来微调模型,他们实际部署的模型规模会小得多。对于这种大小的模型,英伟达H100在AI推理方面不一定是最经济的选择,目前H100的售价高达40000美元。”

他也指出,d-Matrix面临一个机会窗口,在英伟达等巨头转向这个市场前,他有一段相对空白的时间来展现其价值。

目前,d-Matrix预计今年的收入将不超过1000万美元,主要来自购买芯片进行评估的客户。创始人Sheth表示,d-Matrix预计在两年内的年收入将超过7000万至7500万美元,并实现盈亏平衡。而d-Matrix面临的市场空间是巨大的,Cambrian AI预计到2030年,AI推理芯片的算力功耗比达到每瓦超过1000 TOPS都是可能的。

自主性和成本是AI芯片的生存土壤

d-Matrix等AI芯片创业公司的生存土壤,一方面来自于AI厂商的自主可控需求,无论是微软,Meta,亚马逊这样的巨头,OpenAI,Anthropic这样的超级独角兽,还是Cohere等领先的创业公司,他们都不希望自己的AI算力与单一公司绑定。

另一方面就是AI服务的运行成本问题,对于大模型公司,从长期看,运行AI服务的算力成本会高于训练模型的算力成本,而且在现阶段,AI企业的单个用户的运行成本是亏损状态,总体拥有成本 (TCO) 也高企。对于资金充裕的巨头,这种亏损状态尚可承担,但是对于创业公司来说,则是巨大负担,会拖慢他们的业务进一步扩大的速度。

第三方、低成本的AI推理算力,无论对于巨头,还是对于创业公司,都极为需要。

目前的阶段,AI芯片领域的创业公司面临什么风险?其一当然是英伟达巨头的“垄断”,以及微软、Meta、谷歌、OpenAI这些最大的AI公司自研芯片,再就是与芯片配套的软件生态问题。

而这些问题,d-Matrix都在解决当中。它瞄准了商用中小规模AI模型的市场,也与开源社区合作,打造软件生态,这都能让它在巨头竞争时拥有差异化竞争优势。

本站所有软件信息均由用户上传发布,版权归原著所有。如有侵权/违规内容,敬请来信告知邮箱:764327034@qq.com,我们将及时撤销! 转载请注明出处:https://czxurui.com/zx/90713.html

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

发表回复

评论列表(0条)