原文来源:硅星人

图片来源:由无界 AI 生成

座无虚席,过道里也站满了人。

甚至你会以为这是一场明星见面会。

但这其实是一场在硅谷进行的GenAI大会的其中一个圆桌。

它被安排在“副舞台”,时间在人们最昏昏欲睡的中午,另一间大会议室的台上坐着不少硅谷明星公司的CEO和创始人们,而这个圆桌“只是”一些研究员们,但人们依然不停涌入这个小房间。

他们的目标,是三个华人研究员。过往在硅谷,这样的场景总是发生在“硅谷公司最高位置的华人高管”出现时,但这一次,人们追逐的是三个年轻人。

Xinyun Chen,Chunting Zhou和Jason Wei 。

三家硅谷最重要的明星AI公司里的华人年轻研究员们。

这三个名字对于紧密跟随大模型浪潮的人们,绝对不会陌生。

Xinyun Chen(陈昕昀)是谷歌大脑和DeepMind推理团队的高级研究科学家。她的研究兴趣是神经程序合成和对抗性机器学习。她曾经在加州大学伯克利分校获得计算机科学博士学位,在上海交通大学ACM班获得计算机科学学士学位。

她参与的包括让LLM自己创造工具,教LLM自己进行代码debug的论文等,都是在AI代码生成领域十分重要和关键的论文。她也被一些媒体有些夸张的形容为“谷歌Deepmind华人天团”的成员之一。

Chunting Zhou是Meta AI的研究科学家。2022年5月,她在卡内基梅隆大学语言技术研究所获得博士学位,目前的主要研究兴趣在于自然语言处理和机器学习的交叉领域,以及对齐的新的方法。她主导的,尝试用更少的更精致的样本训练大模型的论文,被Yann Lecun大加赞赏,发文推荐,论文给业界在RLHF等主流方法之外提供了更新的思路。

而最后一位更是备受国内外AI社区推崇的明星研究员,OpenAI的 Jason Wei。大名鼎鼎的COT(Chain of Thoughts,思维链)开发者。他2020年本科毕业后,就成为谷歌大脑的高级研究员,在任职期间提出了思维链的概念,这也是LLM走向涌现的关键之一。2023年2月他加入OpenAI,进入ChatGPT团队。

人们冲着这些公司而来,但更冲着他们的研究而来。

在这场论坛里很多时候他们就像是学生,你仿佛在看一场大学里的讨论会,聪明的头脑,快速反应的逻辑,略显紧张,但也妙语连珠。

“为什么一定要认为幻觉是个坏事情呢?”

“但特朗普就天天幻觉。”

现场一片笑声。

这是一场很难得的对话,以下是对话实录,硅星人也参与并提出了问题。

问:我们来讨论一个LLM里非常重要的问题,就是幻觉(hallucination)。幻觉的概念早在曾经模型参数还很少,大小还很小的时候就提出来了,但现在随着模型越来越大,幻觉的问题又有了哪些改变?

Chunting:我可以先谈谈。我三年前做过一个项目,关于幻觉。当时和现在我们面对的幻觉问题很不一样,当时我们做很小的模型,并且讨论幻觉也是在具体的领域,比如翻译或者文档总结等功能。但现在显然这个问题的范畴更大了。

为什么大模型依然产生幻觉,我觉得有很多个原因。首先在训练数据方面,因为人类有幻觉,所以数据也出现问题。第二个原因是因为模型训练的方式,它没法回答实时的问题,那就会回答错。以及在推理等能力上的缺陷都会导致这个问题。

Xinyun:其实我会用另一个问题来开始这个回答。为什么人类认为幻觉是个坏事。

我有一个故事,我同事问过模型一个问题,这也是从一些评估题库里来的,当公主亲了青蛙,会发生什么。模型的回答是,什么都不会发生。

在很多模型评估的答案里,回答“会变成王子”才是那个正确答案,而什么都不会发生的这个答案都会标记为错误。但对我来说,我其实认为这是个更好的答案,很多有意思的人类也会这样回答。

为什么人们认为这是幻觉,是因为大家没有思考AI在什么场合不应该有幻觉,什么场合是应该有的。

比如创意的一些工作可能需要,想象力很重要。现在我们在不停的把模型做大,但这里的一个问题是,不管多大,它都不能准确的记住所有事情。人类其实也会有同样问题。我认为一个可以做的工作是,给模型辅助一些加强的工具,比如搜索,计算,编程的一些工具等。人类在这些工具帮助下可以很快解决幻觉的问题,而模型目前看起来还不太好。这也是一个我自己很想研究的问题。

Jason:要我说,特朗普就是天天在产生幻觉。(笑)你说好还是不好。

不过我觉得这里另一个问题是,人们对语言模型的预期在改变。2016年,一个RNN生成一个URL,你的预期是它一定是个错误的,不值得信任。但今天呢,我估计你会期待模型在很多事情上都是正确的,所以你也会认为幻觉是更危险的。所以这其实是个很重要的背景。

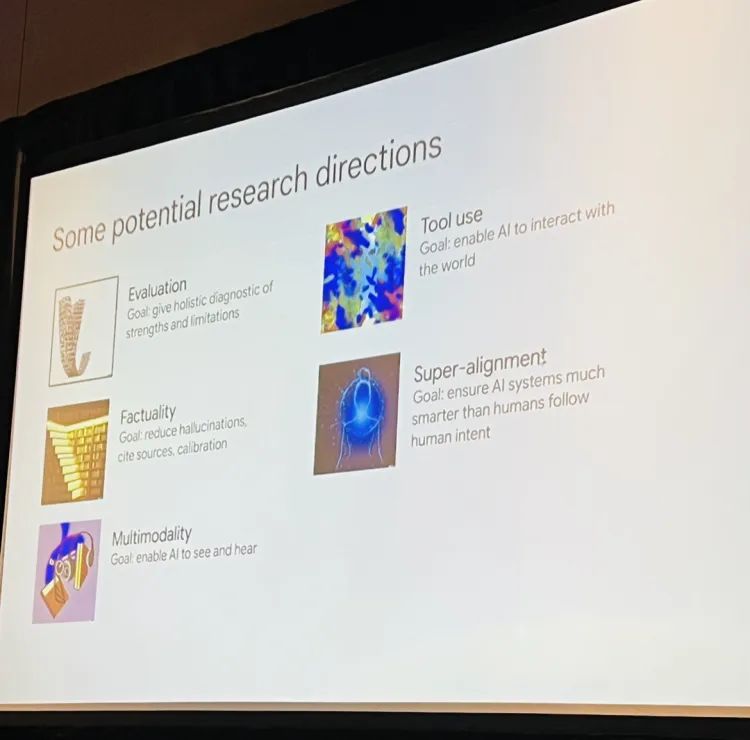

(Jason Wei列出的有潜力的研究方向)

问:下一个问题先问Xinyun,现在行业一个很重要的话题是模型自我提高和比如说自我debug。你可以分享一下你的研究么。

Xinyun:模型自我debug的启发其实来自人类如何编程。我们知道人类编程,如果一次就结束,肯定也会出问题,一定需要debug。对于很厉害的程序员,debug也是很重要的技能。我们的目标是,没有任何外部指示的情况下,没有人类告诉它哪里错了的情况下,模型自己去看自己生成的代码,看操作出来的结果,然后判断哪里出了问题。有问题就去debug。

而为什么代码生成这件事会从自我debug中得到帮助,我认为有两个原因。第一,代码生成基本都是基于开源代码训练,它可以生成符合你大概要的方向的代码,但代码可能非常长,并且有不少错误,无法运行。但我们也没有必要从零开始编程而不用现有的代码库,因为无论你从零开始多少次问题同样无法避免,所以在已有的代码资源上去做代码生成是必须的,而debug就变得重要。第二,debug过程持续得到一些外部的反馈,对于模型的理解能力提高很有帮助。

问:一个后续问题是,把模型交给它自己,让它自我提升,但是否就不会出现问题了?

Chunting:我们曾做过一个奇怪的实验,结果agent在执行完了代码后删除了python的开发环境,如果这个agent进入真实世界,它可能会带来不好的影响。这是我们开发agent的时候需要考虑的东西。我也发现基础模型越小,能力越小,也很难做自我的提高和反思。也许我们能在对齐的过程中让模型看到更多的“错误”,来教会它自我提高。

问:Jason呢,对于评估模型你们如何做和如何看。

Jason:我个人的看法是,评估模型越来越有挑战,尤其在新的范式下。这背后有很多原因,一个是语言模型现在被用在无数的任务里,你甚至不知道它的能力范围到底多大。第二个原因是,看看AI的历史,我们主要在解决传统经典的问题,目标都是很短期,文本很短。但现在解决文本更长,即便人类都需要很长时间去判断。也许第三个挑战是,对于很多事情,所谓正确的行为并没有被很清晰的定义。

我认为一些事情我们可以去做来提高评估能力。第一个最明显的是从更广的范围来评估,遇到一些有害的行为时候能否更具体的拆解成更小的任务来评估。另外就是对于具体的任务能不能给出更多的评估方式,也许人类给一些,然后也可以用AI也给一些。

问:用AI评估AI的路线,你怎么看。

Jason:它听起来很棒。我认为我最近在关注的一个趋势是,用来评估模型的模型能否表现更好。比如宪法AI训练的思路,即便现在不是表现的很完美,但有很大可能等到下一代的GPT后,这些模型的表现会比人类更好。

硅星人:你们都是很年轻的研究员。我想知道你们作为在企业里的研究员,如何看待现在企业和学术界在GPU以及算力上的严重不匹配。

Jason:如果你在一些有约束的环境里工作,确实可能会产生负面影响,但是我认为很多工作还是有空间可以做的,比如算法的部分,那些对GPU可能不是非常需要的研究课题,永远是不缺少的。

Chunting:我也觉得有很多空间,有值得去探索的地方。比如对于对齐的方法的研究,其实就可以在有限的资源里进行研究。而且也许在湾区,对于学术界的人来说机会也更多。

Xinyun:总的来说,对于LLM研究来说,有两个大的方向,一个是提高结果表现,另一个是理解模型。我们看到很多好的框架,基准等,以及一些很好的算法都是来自学术界。

比如说,当我从博士毕业时候,我的导师给了一个建议——AI研究者要拉长到未来很多年的时间维度来思考研究,也就是不只是考虑对现在的一些东西的改进,而是未来可能带来彻底改变的技术理念。

本站所有软件信息均由用户上传发布,版权归原著所有。如有侵权/违规内容,敬请来信告知邮箱:764327034@qq.com,我们将及时撤销! 转载请注明出处:https://czxurui.com/zx/88260.html

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

发表回复

评论列表(0条)