原文来源:硅星人

图片来源:由无界 AI生成

云!

如果每天看媒体上关于大模型的报道,你会被各式各样的模型和昙花一现的吓人应用迷乱了眼睛,以为模型的未来就在下一个一统全局的全能模型身上。所以AI这事似乎就是OpenAI或者Anthropic 们中的一个最终胜出的故事。

那些以惊人速度和额度完成的融资也似乎证明着这样的观感。

被视为OpenAI最大对手之一的Anthropic,在以20亿为单位,月为周期的一轮轮融资——10月27日,谷歌表示已经向其再次投资20亿美元,此前的一个月不到亚马逊刚向其投资了40亿美元,它的以上下文长度等特性为竞争点的模型Claude被认为是ChatGPT最有力的竞争者之一。而与此同时,OpenAI也在集结各种资源,它的一举一动背后,软银,微软,苹果都以各种方式与它传着绯闻。

然而事实上这并不是事情的全部。

对于从业者来说,故事的另一面,其实体悟更加深刻:

当红炸子鸡们面对的有钱有意愿者众多,看似充满自由选择,显然拿那些钱多事少的投资者的美金是更好的选择,然而,他们最终却都纷纷选择了大厂,甚至是对他们虎视眈眈的大厂,只因一件事——他们有云计算能力。OpenAI成功路上微软Azure的贡献被说过太多次,Anthropic现在更是同时给自己保证了谷歌和亚马逊的云算力支持,它表示,融资很重要的目的之一是要为自己构建算力保障来训练下一代的模型。

这是大模型对云的需求的绝佳证明。

在10月31日的云栖大会上,阿里云的一系列数据也在讲着同样的事情。

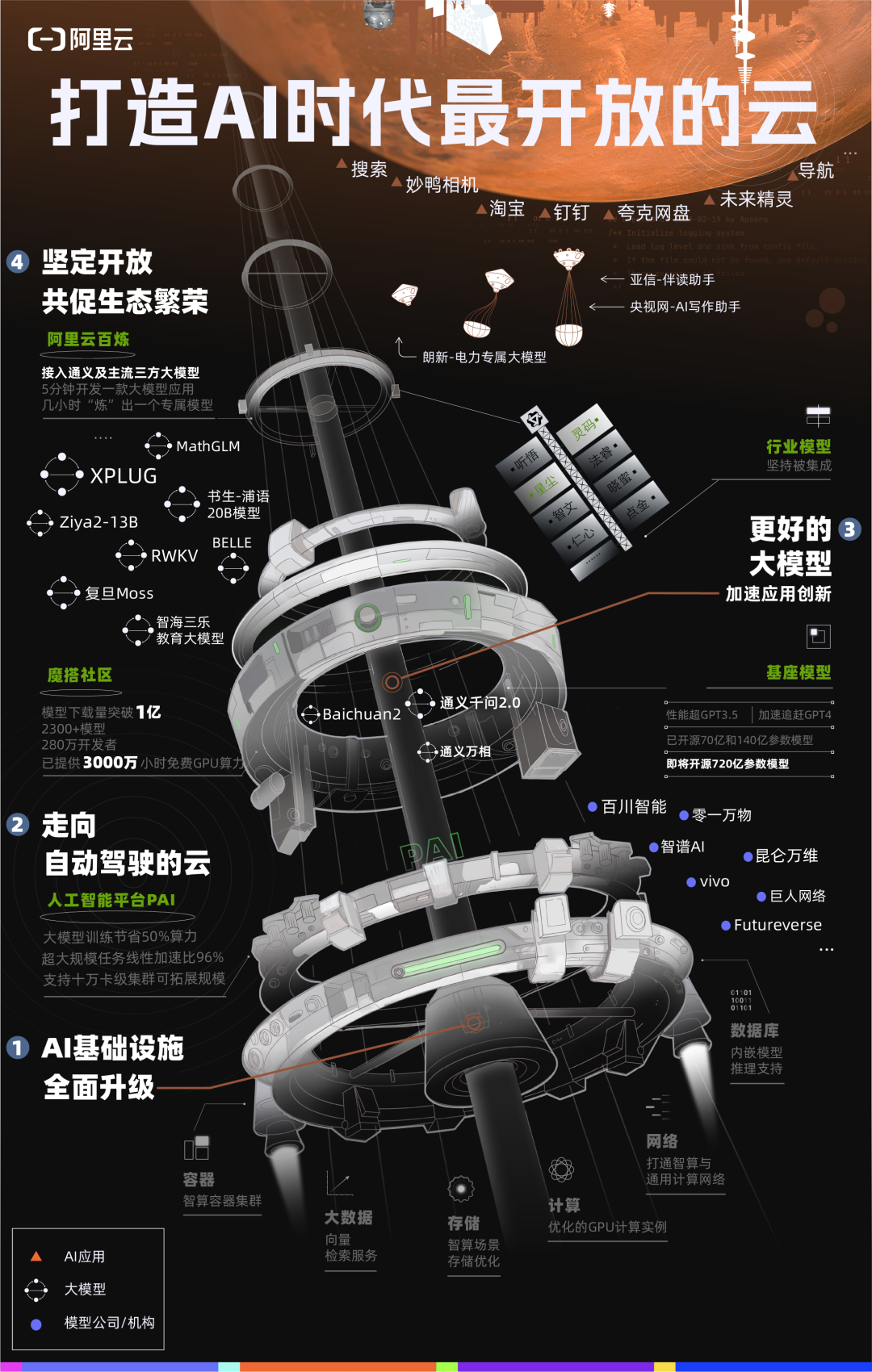

阿里云公布了跑在它的服务之上的部分模型,从自己的通义大模型,到百川智能、智谱AI、零一万物、昆仑万维、vivo、复旦大学等,中国一半大模型公司和机构在此训练。

而这些中国头部主流大模型,也都在通过阿里云对外提供API服务,包括通义系列、Baichuan系列、智谱AI ChatGLM系列、姜子牙通用大模型等。

这些模型追赶着顶尖水平同时,也开始长出自己各自的特点,其中中国最头部的大模型公司之一百川智能,曾创下平均28天迭代一版大模型的纪录,它10月30日最新发布的Baichuan2-192K更是成为全球支持最长上下文窗口的大模型,一次可输入35万字,全面领先Claude2-100K。

这些优势都指向更接地气的应用。百川智能CEO王小川把此形容为“理想慢一步,落地快三步”。而云的基础设施则提供了快的可能。

王小川介绍,百川大模型实现月度迭代的一个重要原因是云计算的支撑。“模型的快速迭代和部署离不开云计算,百川智能和阿里云进行了深入合作。在双方的共同努力下,百川很好地完成了千卡大模型训练任务,有效降低了模型推理成本,提升了模型部署效率。”

云计算的重要性有些被人们忽视的另一个原因,则是AI领域被“全民缺卡”分散走了大量注意力。

“人们太过关注GPU了。”不少大模型从业者对我表示,作为一个计算单元它的确在不停增强,但要解决ai的问题最终需要的是系统化的最优的算力方案。甚至云从诞生起就是解决单一单元能力不够强的问题的一个东西。

“只有卡,只有在论文里惊艳的模型,都不够,最终靠云来落地然后实现理想。”他说。如果你仔细竖起耳朵听听这些真正的模型生态一线的参与者的“呐喊”,那么可能就会听到一个字:

云!

AI的未来如何发展,在今天比任何时候都更取决于云。

一朵新的云

但这绝对并不意味着已经建立起优势的云厂商就能躺赢。

看一看最近谷歌与微软同日发布财报后发生的事情就会知道。

10月25日谷歌发布了营收超预期的财报,同比增长11%,核心广告业务也增长了9%。但之后股价却应声下跌了。原因只有一个,云计算增长了22%,但市场认为还不够。尤其是微软在同日发布的财报显示,其智能云部门成为最大收入来源。

巨头们发现,自己曾经被津津乐道的广告等业务被放在一边,市场第一次对云计算的情况如此在意,因为与尚且虚无缥缈的模型直接带来的收入相比,云计算被认为是可以观测的指标。这个指标背后指向云厂商面对AI带来的挑战时自身的应变能力。

就连份额第一的AWS也感受到了压力,亚马逊对于Anthropic的投资也发生在这几份财报期间。有报道称,微软Azure的收入已经有3%来自AI,它的客户包括OpenAI的大量用户,AWS则开始强调它对各类模型的服务。给Anthropic砸了20亿后,立刻宣布这家模型公司之后的LLM将用AWS的训练加速芯片Trainium和推理芯片Inferentia来打造。此外,像微软财报中强调的新的集群方案,AWS全托管的基础模型服务Bedrock等,也都在强调着自己为新的AI需求而做的改造。

“面向智能时代,阿里云将通过从底层算力到AI平台再到模型服务的全栈技术创新,升级云计算体系。”决定着阿里云技术路线的周靖人在云栖大会上也给出了他的答案。阿里云此次体现出的改变果断而透彻,从肌理到内核面向AI全部改造。

根据周靖人的介绍,阿里云首先用大模型对自己进行了改造,有超过30款云产品接入了大模型能力。

例如,阿里云大数据治理平台DataWorks新增了全新的交互形态——Copilot,用户只需用自然语言输入即可生成SQL,并自动执行相应的数据ETL操作,整体开发与分析可提效30%以上。

周靖人形容这是云计算的自动驾驶模式,将大幅提升开发者用云的效率和体验。

同时,阿里云还升级了人工智能平台PAI。PAI底层采用HPN 7.0新一代AI集群网络架构,支持高达10万卡量级的集群可扩展规模,超大规模分布式训练加速比高达96%,远超业界水平;在大模型训练任务中,可节省超过50%算力资源,性能全球领先。

这些专业术语略显复杂,用直白的客户案例来解释,当天周靖人也分享了一些案例:“通过我们的PAI平台,能够帮助推理的优化,能够帮助小红书节约成本30%,能够真正意义上推动小红书快速的业务增长,以及各种各样的业务需求。”

包括阿里云在内的云厂商们本质上在做的是摸索新的基础设施。大模型等AI技术带来的改变是全栈的,从模型底层到训练思路,从数据需求到交互界面,都在变化,甚至需要“重做”,此前有从业者就表示,某种意义上,哪怕是GitHub等现在依然发挥重要作用的平台等,也是上一个时代的产物,新的时代需要的新的基础设施也要完成全栈改造。

阿里云一切改造的出发点,就是周靖人早早提出的MaaS(model as a Service )。

“模型本身就是数据和计算高级的抽象。”周靖人在当天和我们的小范围交流里说。

“举个例子,以前我们用的更多是日志或者数据库的数据。模型是什么?模型是加工过后的数据集合,这是一个高度知识的抽象。所以从这个角度来讲,大家可以想原始的数据是更原始的生产材料,依赖于原始的算力。而今天模型是一个加工层,是基于数据原材料产生的更加抽象的生产元素,大家可以利用这样的生产元素去做更高维的业务系统开发。以前我们有Infrastructure,这是一个生产元素,今天模型也是一个生产元素。”

这种围绕模型的新的基础设施,需要比过去更复杂的系统能力。

在AI应用上的门槛越来越低的同时,提供符合新AI时代需求的云计算的门槛只会越来越高。要探索这个新的东西显然需要对云计算的核心技术的掌握,需要对大模型的技术有真正上手过的理解——知道自己有什么,也知道客户需要什么。

“基于我们在云计算的积累,我们已经搭建了完善的AI基础设施。通过今天我们对网络、存储、调度、编译、容错等等方面一系列的优化。我们建立了完善的AI大模型的训练平台。”周靖人表示。“同时,通过我们一系列优化再结合云本身的高弹性,能够为大家提供一个非常完善的模型训练及推理的服务。”

而在当天,阿里云还发布了自研的千亿级参数大模型通义千问2.0。

通义千问2.0在性能上取得巨大进步,在复杂指令理解、文学创作能力、通用数学能力、知识记忆、幻觉抵御等能力维度上显著提升,综合性能已经超过GPT-3.5,加速追赶GPT-4。

阿里云还发布了通义千问APP,用户可直接体验通义千问2.0;同时,通义大模型官网全面更新,新增多模态交互和插件功能,用户除了可通过图片与通义千问2.0交互外,还能调用更多丰富的插件新能力。

周靖人表示,“通义千问2.0更成熟了,也更好用了”。

开放,开放,还是开放

改造如此全面,自然也就带来一个疑问:既做模型也做基础设施最终会不会变成既做裁判又做运动员的局面。

阿里云给出的答案是最大程度的开放。

阿里云是国内最早开源自研大模型的科技公司,目前,阿里云已开源通义千问7B、14B版本,下载量突破百万。在现场,周靖人宣布通义千问72B模型即将开源,将成为中国参数最大的开源模型。

其实这种开放也不是ChatGPT之后的事情。在一年前的云栖大会上,阿里云开始建设模型社区魔搭,其实当时最早一批开源的正是阿里云自己的核心模型。当时魔搭的计划就是通过阿里云自己交出压箱底的东西来带动大家改变AI过去封闭的状态,用开放来真正让它走向大众。

周靖人透露,魔搭社区今天现已聚集2300多款AI模型,吸引280万名AI开发者,AI模型下载量突破1亿,成为中国规模最大、开发者最活跃的AI社区。这个成绩是外界对它开放这件事最直接的认可。

今天在魔搭社区上,百川智能、智谱AI、上海人工智能实验室、IDEA研究院等已经开源首发他们的核心大模型,阿里云则为开发者们“尝鲜”大模型提供免费GPU算力,截至目前已超3000万小时。

“我们今天的定位就是服务好各种不同需求的客户。”周靖人表示。

在阿里云的生态里,有与复旦大学共同打造的超级计算机,它支持千亿参数的大模型训练,总体算力规模跻身全球前15名。其背后的计算集群由复旦校内的“近思一号”和1500公里外阿里云乌兰察布数据中心的“切问一号”相连组成。

有自研大模型的vivo,从算力和平台功能、训练性能等,到阿里云人工智能平台PAI在大模型SFT监督微调和强化学习方面的训练优化框架,vivo通过和阿里云的合作来更高效迭代大模型。

也有火遍全网的“妙鸭相机”,其相片生成在高峰期量级至少需要几千台GPU服务器,线下部署不切实际,云上部署能为创业公司节省大量成本和时间。而且,妙鸭这样的应用更是代表着一个趋势,就是未来推理的需求会大过训练的需求,这只会让云计算对AI服务的可持续变得更加关键。

这样的一个定位之下,阿里云的大模型更像是阿里过往总在使用的一个思路的延续——最佳实践。它的思考是,只有自己做过最复杂的任务,用它考验了自己的基础设施,才能向外提供更靠谱的服务和技术。而这些努力背后所有的一切最终都为了一个目标——推动AI产业化。

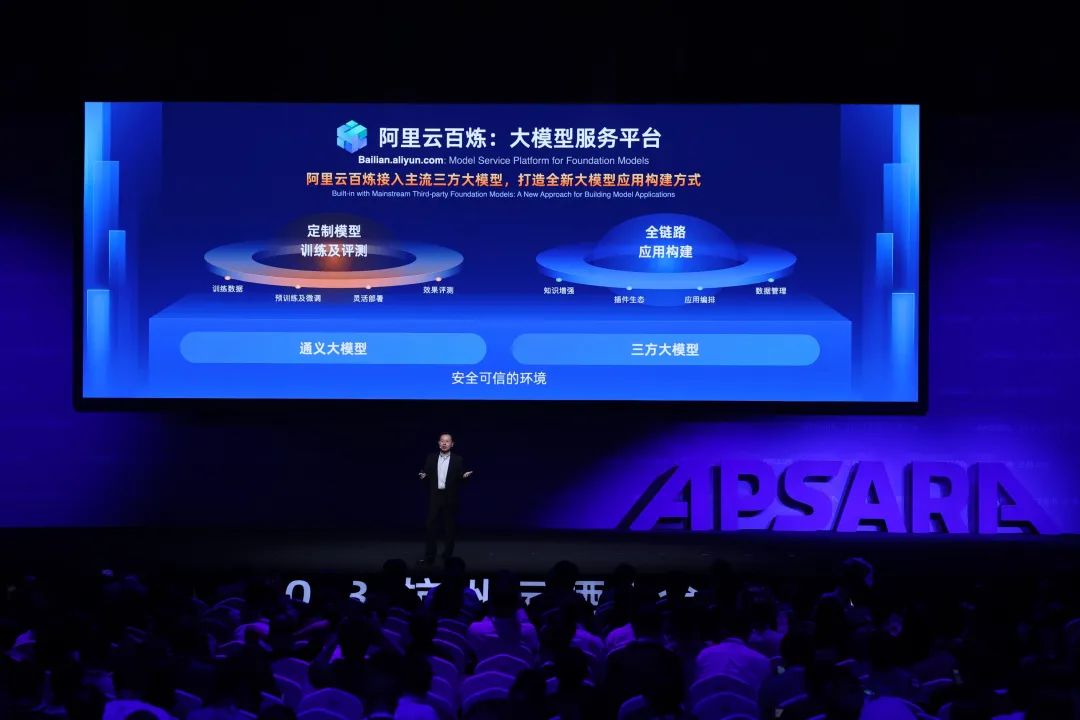

在这样的目标下,阿里云还发布了阿里云百炼,这是一个一站式大模型应用开发平台。阿里云体系化的开放的集大成者。

阿里云称,基于它开发者可在5分钟内开发一款大模型应用,几小时即可“炼”出一个企业专属模型。这里集成了包括阿里云通义大模型系列及国内外诸多三方主流大模型,在帮助开发者选择最合适自己的模型后,它还提供SFT、LoRA等多种微调方式,让你能微调自己的模型。训练完成还可以通过阿里云一键部署。开发应用也大大简化,甚至最新的agent和其他插件等供用户选择。

“每一个环节、每一个人群都是今天整个开发者生态的重要的组成部分。”周靖人表示。

“我们的目标是把阿里云做成一个最开放的云,我们希望今天阿里云不能只服务一类客户,我们今天所有的客户、各个提到各种各样的客户,都能够有效的为他们提供人工智能时代的支持,能够帮助到他们去在自己擅长的领域去做创新、去突破。这是我们的目标,也是今天我们产品设计背后的一个思考。”

在“理想落后一步”的今天,热闹的模型生态不仅在实际的发展里需要云,而且云计算对中国科技公司们的启发也对今天的AI和模型从业者无比重要。

中国的云计算发展历程一直有一种象征意义,就是当我们有强大的技术开发人才和最广泛的产业应用需求时,如何自发的向下掌握底层技术。而当你处于一定技术后发劣势时,这样的机会只会出现在大的技术体系全面变革时。

而当新的技术革命再次到来,底层技术再次需要重构时,云计算成了中国的模型继续和先进同行掰手腕的底气和本钱,也是启发和警示。在今天AI产业和应用加速的同时,有一个我们自己的最前沿水平的技术底座,并基于它形成一种开放和某种意义上互助的关系,对于整个生态一起进步将变得都很重要,对于时刻提醒我们如何把握这一次技术革新也很重要,它甚至有希望在不断努力下变成这场竞争里的优势。

本站所有软件信息均由用户上传发布,版权归原著所有。如有侵权/违规内容,敬请来信告知邮箱:764327034@qq.com,我们将及时撤销! 转载请注明出处:https://czxurui.com/zx/94351.html

微信扫一扫

微信扫一扫  支付宝扫一扫

支付宝扫一扫

发表回复

评论列表(0条)